隨著人工智能技術(shù)的快速發(fā)展,其在各個領(lǐng)域的應(yīng)用日益廣泛,但同時也帶來了前所未有的安全威脅。尤其在網(wǎng)絡(luò)與信息安全領(lǐng)域,人工智能既可能成為防御的利器,也可能被惡意利用,形成新型的安全挑戰(zhàn)。

人工智能可能被用于發(fā)動更智能、更隱蔽的網(wǎng)絡(luò)攻擊。傳統(tǒng)網(wǎng)絡(luò)安全防御主要依賴規(guī)則和特征匹配,而人工智能驅(qū)動的攻擊可以自我學(xué)習(xí)和進化,繞過這些靜態(tài)防御機制。例如,攻擊者可以利用生成對抗網(wǎng)絡(luò)(GAN)制造難以識別的惡意軟件變種,或通過強化學(xué)習(xí)技術(shù)自動化滲透測試,發(fā)現(xiàn)系統(tǒng)漏洞。

數(shù)據(jù)隱私面臨嚴峻挑戰(zhàn)。人工智能系統(tǒng)依賴大量數(shù)據(jù)進行訓(xùn)練,這些數(shù)據(jù)中可能包含敏感信息。如果數(shù)據(jù)在收集、存儲或處理過程中遭到泄露,或被用于訓(xùn)練惡意模型,將對個人隱私和企業(yè)機密構(gòu)成嚴重威脅。深度偽造技術(shù)的濫用更是加劇了這一風(fēng)險,可能被用于制造虛假信息、進行身份欺詐等。

人工智能系統(tǒng)本身也存在安全漏洞。對抗性攻擊可以通過輕微擾動輸入數(shù)據(jù),導(dǎo)致AI系統(tǒng)做出錯誤判斷。在自動駕駛、醫(yī)療診斷等關(guān)鍵領(lǐng)域,這種漏洞可能造成嚴重后果。模型竊取、數(shù)據(jù)投毒等攻擊手段也在不斷演進,威脅著AI系統(tǒng)的完整性和可靠性。

面對這些挑戰(zhàn),網(wǎng)絡(luò)與信息安全軟件開發(fā)需要采取多管齊下的策略:

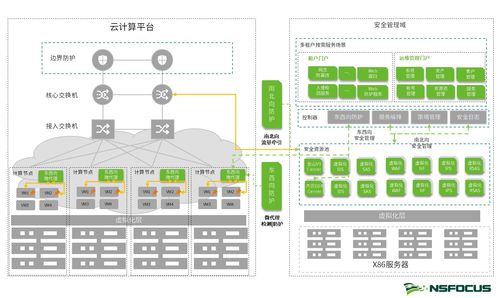

- 開發(fā)智能威脅檢測系統(tǒng):利用機器學(xué)習(xí)算法分析網(wǎng)絡(luò)流量、用戶行為等數(shù)據(jù),實時識別異常模式和潛在攻擊。

- 加強數(shù)據(jù)保護機制:采用差分隱私、聯(lián)邦學(xué)習(xí)等技術(shù),在保證模型性能的同時保護訓(xùn)練數(shù)據(jù)的隱私。

- 構(gòu)建魯棒的AI系統(tǒng):通過對抗訓(xùn)練、輸入驗證等方法提高AI模型的抗干擾能力,確保其在惡意環(huán)境下的穩(wěn)定性。

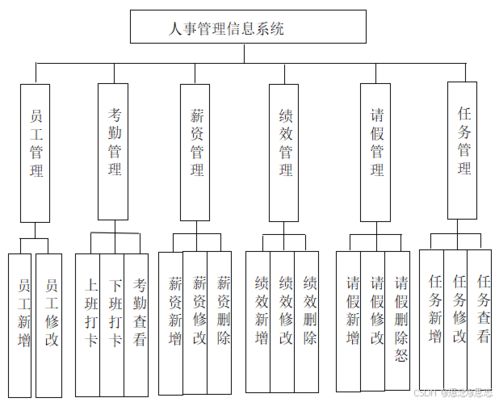

- 建立AI安全治理框架:制定嚴格的數(shù)據(jù)使用政策、模型審計流程和應(yīng)急響應(yīng)機制,形成全面的安全保障體系。

- 促進跨領(lǐng)域合作:網(wǎng)絡(luò)安全專家、AI研究人員和政策制定者需要密切協(xié)作,共同應(yīng)對新興威脅。

人工智能既帶來了新的安全威脅,也提供了創(chuàng)新的防御手段。只有通過持續(xù)的技術(shù)創(chuàng)新和全面的安全策略,我們才能在享受AI帶來的便利的有效防范潛在風(fēng)險,構(gòu)建安全可靠的數(shù)字未來。